Prompt Cacheとは

Prompt Cacheとは、同じプロンプトを短時間に繰り返し送信した際、処理済み部分を再利用してレスポンスを高速化し、対象トークンのコストを最大90%削減できる仕組みです。

検証環境

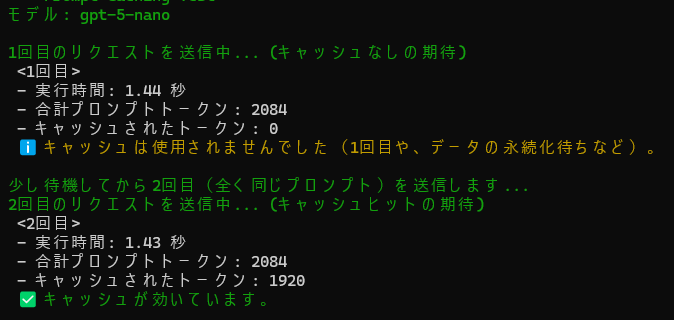

モデル:gpt-5-nano

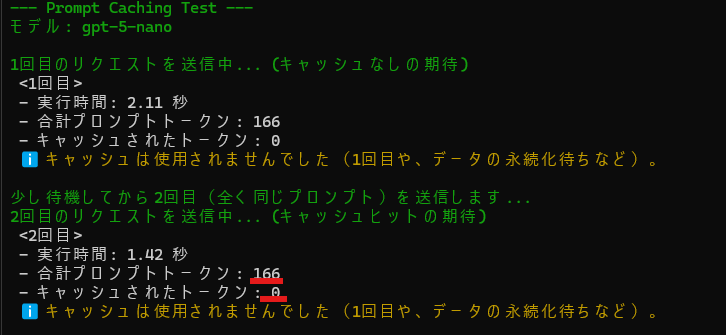

ケース1:1,000トークン未満の入力プロンプト

166トークンではキャッシュされない。

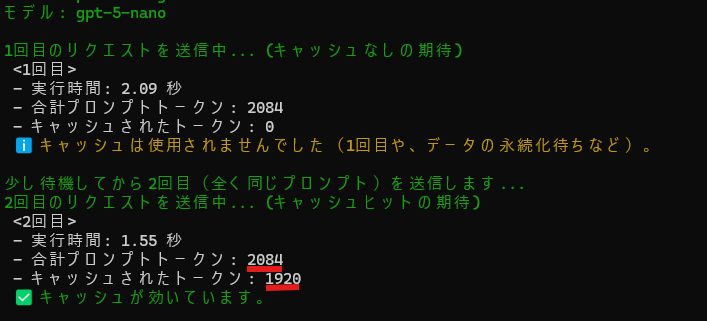

ケース2:1,000トークンを超える入力プロンプト

キャッシュが効いた。

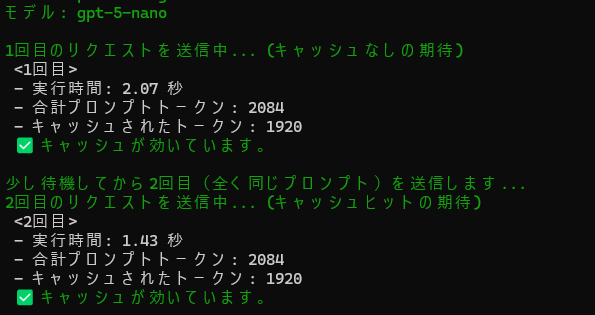

ケース3:5分後に再実行

5分後だとまだ有効。

ケース4:15分後に再実行

1回目はキャッシュが効かなかった。

検証結果

- トークンが短すぎる(1,000トークン未満)場合、キャッシュの対象にはならない。

- 10分くらいアクセスがないとキャッシュは破棄される。

- 計測方法や環境の問題かもしれないが「高速化」についてはやや腑に落ちない結果だった。